大数据集群规划案例

1.集群节点与硬件规划

2.部署目录规划

3.YARN资源队列规划

4.Kafka规划1.集群节点与硬件规划

比如业务系统数据量每天增量 50T,保留周期为 30 天,那么 HDFS 存储容量为 50T * 30 天 * 3 副本 * 2 倍(数据源+清晰加工) = 9000T = 8.79P每个机器的磁盘是 4T * 10 = 40T, 每台机器的可用存储容量为 40T *

0.75 = 30T, 节点预估数量= 9000T / 30 = 300 节点,所以 datanode 的节点最小数量为 300 个,也是 YARN 的 nodemanager 的节点数根据任务量和性能评估 YARN 的节点数是很难的,难以评估,所以

NodeManager节点数可以和datanode节点数保持一致,如果算力负载过高,根据实际情况再扩容即可。

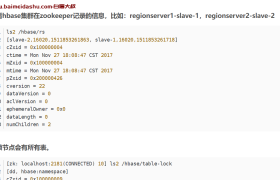

HBase 节点规划:一般开始搭建是根据 HDFS 存储公式计算即可,增加并发的考虑,一般一个 RegionSever 并发为 5000 ~2 万(优化后并发更高),可以根据业务实际并发估计节点数量

Kafka 节点规划:一般开始搭建是根据类似 HDFS 存储公式计算,一般一个 broker 并发为 5 万(优化后并发更高),可以根据业务实际并发估计节点数量

Zookeeper 节点规划:集群开始搭建时 3 节点就够用了,如果发现zookeeper 负载过高或有超时现象时可以考虑扩展到 5 节点集群中的每个组件要做高可用,一般国企会用 CDH,互联网公司会用开源社区版演化自己平台

NameNode 内存一般 100 万个 block 对应 1G 的堆内存,比如我们最大的一个集群的 block 达到了 9000 万,会占内容 90G,NameNode 的内存不只存放 block,我们产线环境配置的是 200G+

集群硬件选择:

1.HDFS 节点配置

主节点 NameNode 主要 CPU/内存配置高些,系统盘做 RAID1,hdfs 要安装在系统盘上,如果有其他的数据盘,可以做 RAID5,容量所需不大,500G~1T 即可

从节点 datanode 内存/CPU/磁盘都有要求,我们产线存储每服务器4T*10=40T 台

2.YARN 节点配置

主节点 ResourceManager 主要 CPU/内存配置高些,系统盘做 RAID1,hdfs要安装在系统盘上,如果有其他的数据盘,可以做 RAID5,容量所需不大,500G~1T 即可

从节点 NodeManager 对 CPU 和内存都有要求

3.HBase 节点配置

主节点 Master CPU 内存中配就行,从节点 RegionServer 内存可以大些

4.Kafka 产线配置

2.部署目录规划

1、OS磁盘建议RAID1,建议200G以上,并且做LVM(逻辑卷),这样可以动态调整OS空间大小,安装包需要安装在OS盘;管理节点的数据盘做RAID5,

namenode的fsimage/editlog、jouralnode的/editlog、zookeeper的数据日志都放在磁盘。

2、数据节点的数据盘做RAID0(一块盘做RAID0,硬件RAID)作为数据盘,文件格式为xfs,并配置noatime,不做LVM,最好是同构。

3.YARN资源队列规划

1资源队列调整案例: 就是根据开发 提的参数 ,调参数问题, : 连接

2. 修改用户 yarn 资源分配 : 连接

欢迎来撩 : 汇总all