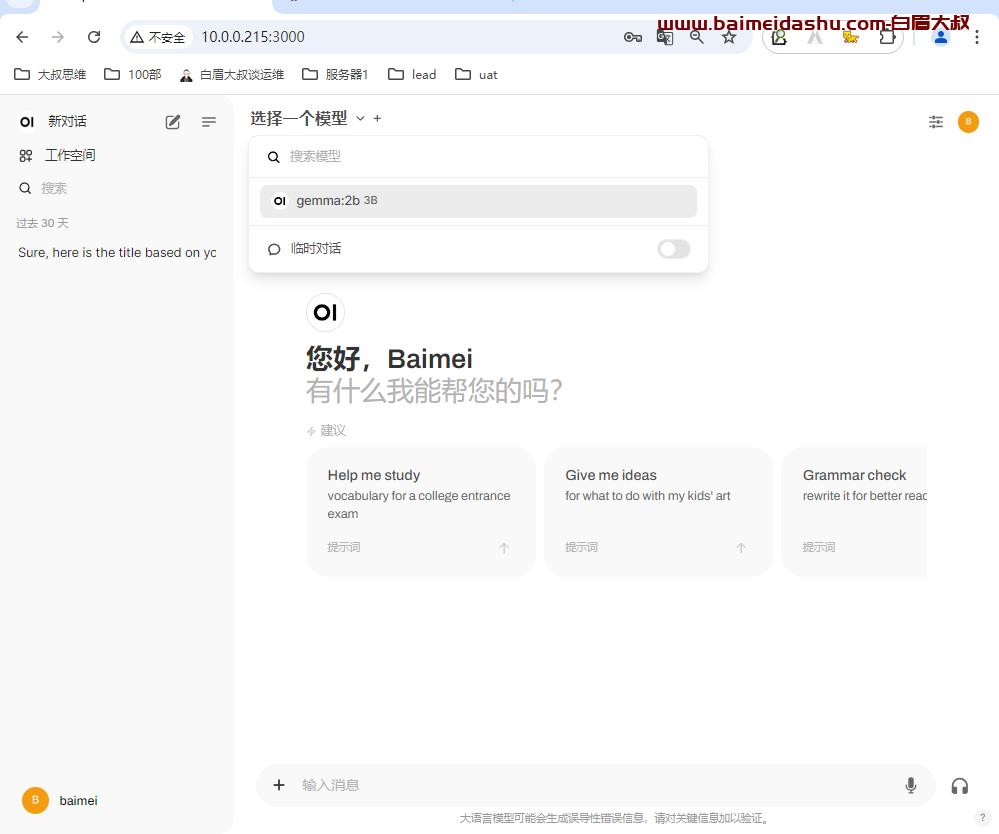

2个工具 ,ollma 和open webui

ollama 是集成了各种大模型, open webui 可以更好的界面化操作我们的知识库

1-安装ollama

下载:

https://ollama.com/download我们用docker 的形式去跑

docker run -v /ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

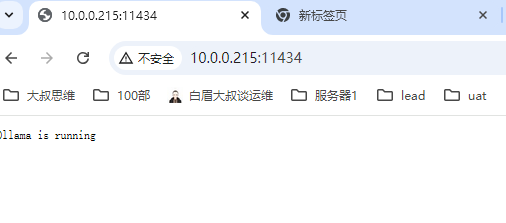

验证:

访问: ip:11434

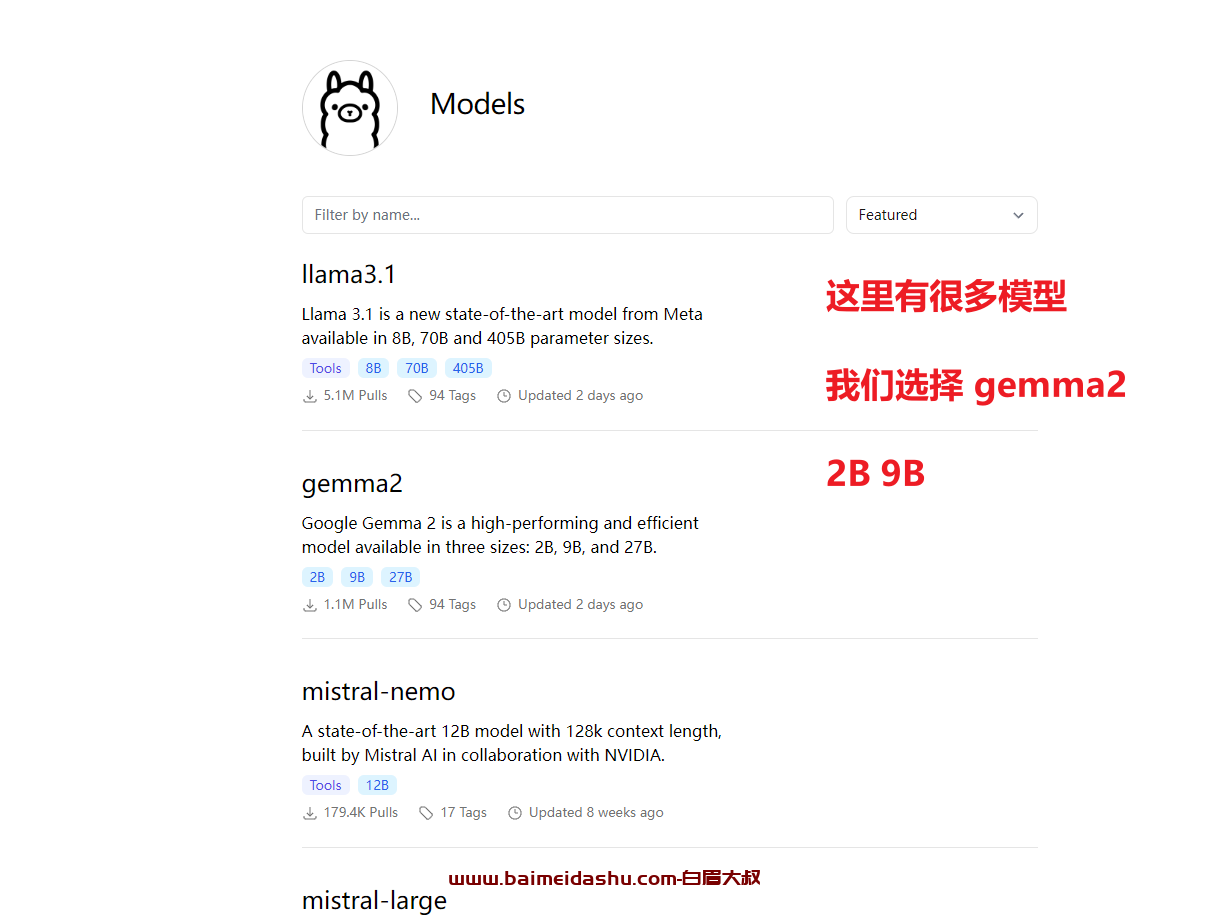

2-下载大语言模型:

https://ollama.com/library/gemma2

还可以选择千问2(对中文特别友好)

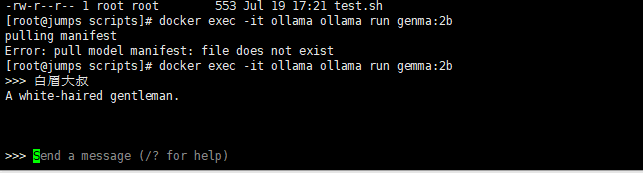

怎么下载呢?

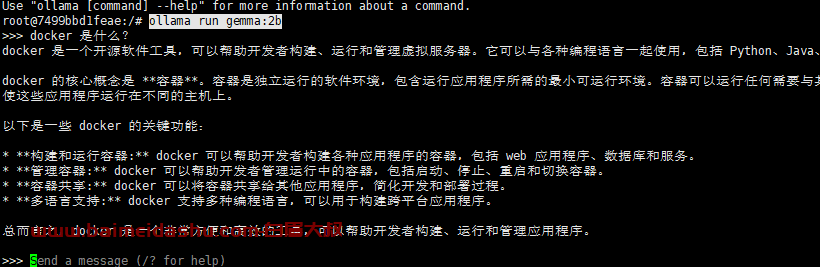

docker exec -it ollama ollama run gemma:2b

其他模型:

docker exec -it ollama ollama run deepseek-coder:6.7b-base

如果出现:

我们可以进入 ollama 容器中:

docker exec -it ollama /bin/bash然后执行 运行模型:

ollama run gemma:2b

这样就可以调用 问题了

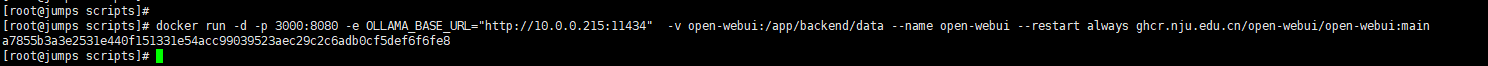

3-安装open ui

docker run -d -p 3000:8080 -e OLLAMA_BASE_URL="http://10.0.0.215:11434" -v open-webui:/app/backend/data --name open-webui --restart always ghcr.nju.edu.cn/open-webui/open-webui:main

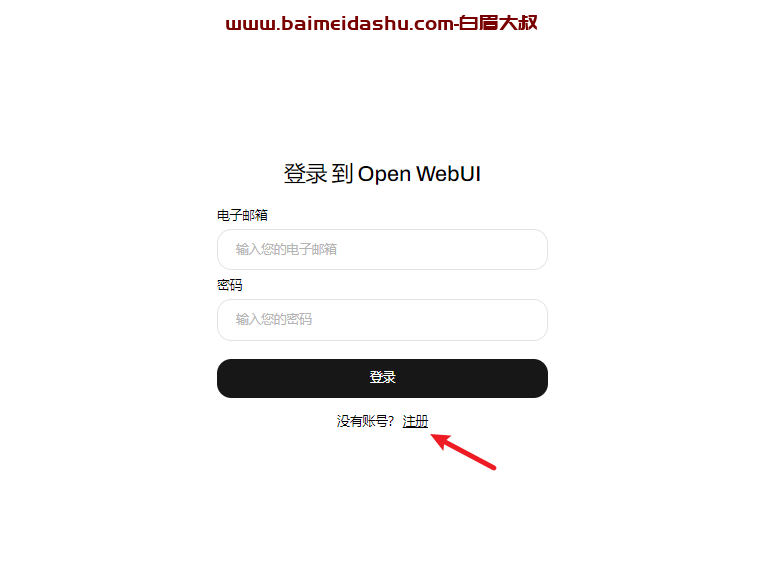

http://10.0.0.215:3000/auth先注册:

5-其他web 界面推荐 -本地调试特方便

设置:

#人工智能 在Linux下使用Docker容器快速构建本地AI问答知识库,可加载各种大语言模型,例如千问。#云计算 #ai人工智能 #Docker #Linux

#人工智能 在Linux下使用Docker容器快速构建本地AI问答知识库,可加载各种大语言模型,例如千问。#云计算 #ai人工智能 #Docker #Linux - 抖音 (douyin.com)

欢迎来撩 : 汇总all